Mit jedem Jahr in der IT wird man irgendwie mehr und mehr betriebsblind und verlässt sich auf Tools und Vorgehensweisen, die man “schon immmer so macht”. Leider ist das gerade in dieser Branche sehr fatal, da es fast täglich neue Möglichkeiten gibt.

Mein Umstieg auf den Mac hatte mir bereits gezeigt, was ich so lange schon verpasst hatte. Kurz darauf wechselte ich vom Standalone-MP3-Player mit manueller Ordnersortierung zu iTunes und war ganz begeistert von der viel intuitiveren Art, seine Musik zu verwalten – jede Datei gibt es nur einmal, aber man kann sie beliebig oft einordnen.

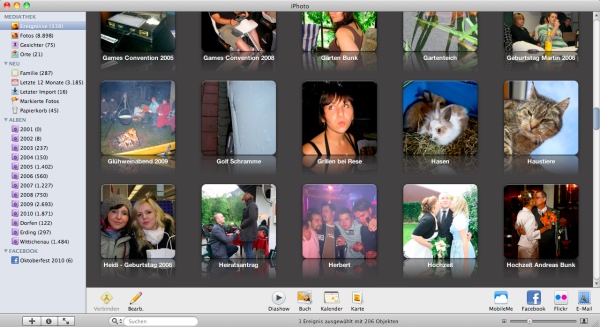

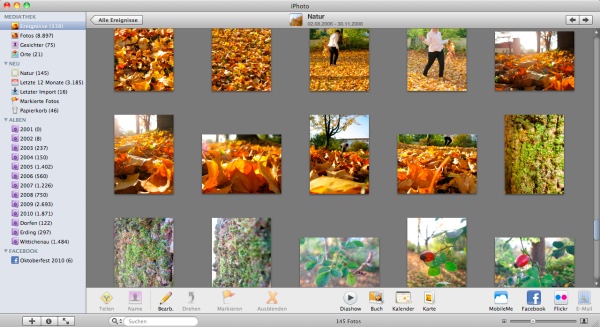

Tja, und was soll ich sagen, die gleiche blöde Angewohnheit hatte ich mir für Fotos beibehalten. Fotos in Ordnern zu organisieren ist einfach nur 1.0. Nachdem ich die Vorzüge von von iPhoto gesehen habe, frage ich mich noch immer, warum ich so lange damit gewartet habe. Ich muss allerdings gestehen, dass ich iPhoto schon einmal probiert hatte, von seinem zusätzlichen Speicherbedarf aber abgeschreckt war. Nachdem ich nun aber ca. 20Gb an Bildern importiert habe und dies “nur” 1 GB zusätzlichen Speicher für Metadaten belegte, hatte sich dieser zusätzliche Bedarf schnell wieder relativiert.

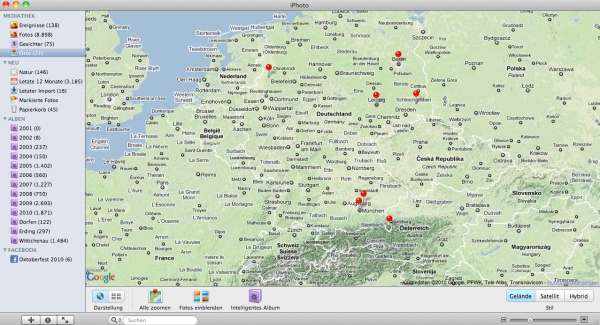

Aber kommen wir zu den Vorteilen: iPhoto ist im Prinzip iTunes für Fotos. Jedes Bild wird nur einmal physikalisch abgespeichert, kann dann aber beliebig organisiert werden. Es gibt intelligente Ordner, mit denen man z.B. alle Fotos eines Ortes oder Datum oder beides kombiniert usw. anzeigen lassen kann. Genauso gut kann man aber auch Alben anlegen und beliebige Fotos darin platzieren. Außerdem kann man Tags vergeben, bewerten, bearbeiten usw. Und das alles geht super schnell und flott. Noch nie bin ich so flink durch meine Bilder gebrowsed. Neben Text-Tags kann man auch die Orte angeben, an denen die Fotos geschossen worden – falls dies nicht bereits von der Kamera / dem Handy erledigt wurde. Anschließend kann man auf einer Google-Maps Karte die Orte sehen, von denen man Fotos hat:

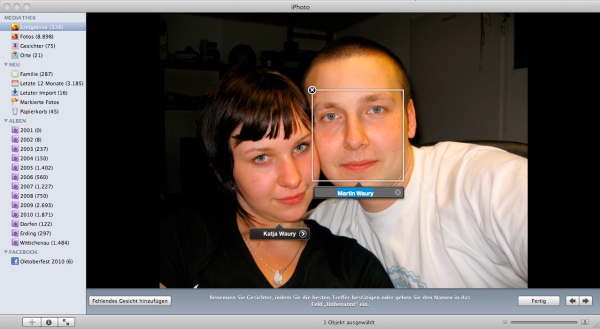

Aber das richte Killerfeature ist die Gesichtserkennung: Ähnlich wie in Facebook kann man Personen auf Bildern markieren, nur das iPhoto nach ein paar Beispielen die einzelnen Personen automatisch erkennt. Und das funktioniert mit etwas Übung relativ gut. Natürlich sind dafür Fotoqualität, Ausleuchtung usw. entscheidend, aber trotz Wiedrigkeiten funktioniert es in gefühlt 80% aller Fälle. Und das macht das Taggen einzelner Bilder ungemein einfacher. Seit dem neusten Update werden auch gleich während der Namenseingabe Vorschläge aus dem Adressbuch übernommen.

iPhoto kann natürlich auch direkt auf angesteckte Kameras zugreifen und die darauf befindlichen Fotos importieren. Auch RAW-Bilder sind kein Problem und können auch direkt im Programm nachbearbeitet werden.

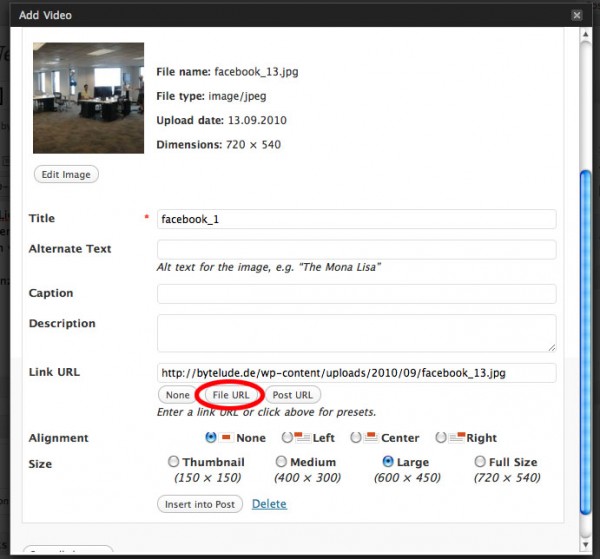

Nun hat man seine Bilder in iPhoto drin, vertaggt usw., aber was stellt man damit an? Neben dem einfachen Betrachten kann man Bilder bzw. Alben direkt bei Facebook hochladen, wobei sogar die Gesichts-Tags mit übernommen werden. Auch nachträgliche Änderungen an den Bildern werden zu Facebook übertragen. Natürlich ist auch der Versand per Mail kein Problem, denn auch das geht direkt aus iPhoto heraus.

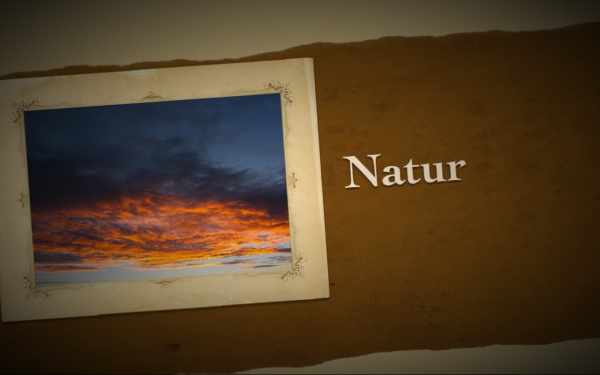

Richtig nett ist auch das Slideshow-Feature. Es gibt verschiedene Themen, wie z.B. das Fotoalbum, bei dem die Fotos virtuell in ein vergilbtes Fotoalbum geklebt sind und die Kamera zwischen den einzelnen Seiten wechselt. Natürlich sind auch der Ken-Burns Effekt, der Polaroid-Stapel sowie die klassische Überblendung vertreten. Richtig klasse ist, dass man die Slideshow mit Musik (vorgegeben oder aus iTunes) unterlegen kann und sich die Slideshow an die Musik anpasst. Alles in allem ein wirklich nettes Feature.

Man kann sogar Fotoalben, Poster und Fotoabzüge über Apple direkt in iPhoto bestellen. Gerade für nicht-Technik-affine Menschen ist das echt cool gelöst.

Und falls man nochmal etwas anderes mit den Fotos vor hat, so gibt es natürlich noch eine Export-Funktion: hier kann man die Originalbilder, verkleinerte Versionen oder direkt Slideshow-DVDs exportieren, um diese dann in anderen Programmen verwenden zu können.

Da iPhoto ein Programm von Apple ist, wird es auch von vielen anderen Programmen unterstützt. Photoshop z.B. kann direkt auf die iPhoto Bibliothek zugreifen. Tools wie Lightroom werden damit eigentlich überflüssig.

iPhoto ist neben iMovie, Garageband und iWeb im iLife Paket von Apple enthalten. Das Paket kostet 79 € und ist auf jeden Fall eine Investition wert.