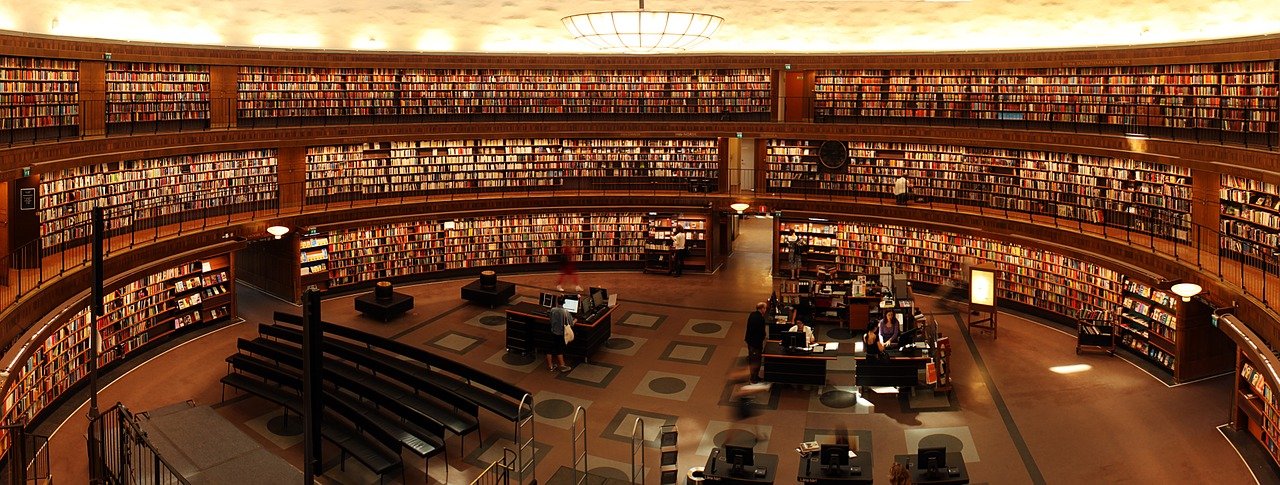

Für Gegenden mit schlechter Internetanbindung oder aber für den Katastrophenfall wäre es doch ganz nett, wenn man die komplette Wikipedia offline auf einem kleinen Raspberry Pi vorhalten könnte. Mittels der Kiwix Software ist dies möglich.

Und so setzt du das Ganze auf:

Lade dir unter

https://download.kiwix.org/release/kiwix-tools/

das entsprechende tar herunter – für Raspberry Pi wäre das dann aktuell

kiwix-tools_linux-armhf-3.1.2-4.tar.gz

und entpacke das Ganze in einen beliebigen Ordner auf dem Raspberry Pi.

Unter

https://wiki.kiwix.org/wiki/Content_in_all_languages

findest du die offline Dumps der jeweiligen Wikipedia Sprachen in unterschiedlichsten Varianten. Die (englische) Erklärung zu den Varianten (min, max, usw.) findest du hier: https://download.kiwix.org/zim/README

Für die meisten Leute dürften folgende Links relevant sein (und auf eine 128gb Karte inkl. Betriebssystem passen):

Wikipedia Englisch (ohne Bilder)

Neben diesen kompletten Dumps gibt es auch die Möglichkeit, nur einzelne Unterbereiche/Themenbereiche der jeweiligen Sprache zu laden. Man kann beliebig viele Pakete laden und auf den Raspberry Pi werfen, die Kiwix Software macht dann alles zusammen verfügbar.

Leg die heruntergeladenen zim Dateien in einen beliebigen Ordner auf dem Raspberry Pi.

Anschließend legst du eine systemd Startdatei für den Kiwix Server unter

/etc/systemd/system/kiwix.service

mit folgendem Inhalt an:

[Unit]

Description=kiwix

[Service]

User=kiwix

Group=kiwix

ExecStart=/[PFAD_ZUM_ENTPACKTEN_TAR]/kiwix-serve -p 8080 /[PFAD_ZU_DEN_HERUNTERGELADENEN_ZIM_DATEIEN]/wikipedia_de_all_maxi.zim /[PFAD_ZU_DEN_HERUNTERGELADENEN_ZIM_DATEIEN]/wikipedia_en_all_nopic.zim

Restart=on-failure

RestartSec=30s

TimeoutSec=30s

[Install]

WantedBy=multi-user.target

Und schließlich aktivierst du den neu erstellten Service noch:

systemctl daemon-reload systemctl enable kiwix.service systemctl start kiwix.service

Damit wird der Server so eingerichtet, dass er jedes mal automatisch startet, sobald der Raspberry Pi gestartet wird.

Im Anschluss kannst du unter der IP des Raspberry Pi auf Port 8080 bzw. auf ihm selbst mit http://127.0.0.1:8080 auf die Wikipedia zugreifen – und das völlig offline.

Um die Daten auf den neuesten Stand zu bringen reicht es, einfach die neuen zim Dateien zu laden und den Server einmal neu zu starten.

![[Quicktip] Wie man auf dem iPhone Zeitrafferaufnahmen einer GoPro Kamera in ein Video umwandelt](https://bytelude.de/wp-content/uploads/2021/01/gopro_1611063812-e1611063841139-825x457.jpg)

![[Quicktip] Wie man Daten von Freenas auf einen USB Datenträger kopiert](https://bytelude.de/wp-content/uploads/2018/07/hard_disk_1530517671-e1530517718148-825x368.jpg)